Websites importeren

Met de ingebouwde scraper kun je automatisch content ophalen van je eigen website of andere webpagina’s. Zo vul je eenvoudig de kennisbank van je AI-agent met relevante informatie.

Waarom is dat handig?

- Je hoeft geen teksten handmatig te kopiëren

- De AI leert direct van bestaande content

- Je kunt meerdere pagina’s tegelijk laten scannen

- Dagelijkse auto-updates zijn mogelijk

Belang van goede data

Zorg dat je AI getraind wordt op correcte en actuele informatie.

Slechte data = slechte antwoorden. Vermijd automatisch gegenereerde of irrelevante pagina’s.

Tip: gebruik vooral FAQ’s, productpagina’s en goed gestructureerde uitlegpagina’s.

Stappenplan: Website toevoegen & scrapen

1. Bewerk je AI-agent

- Ga naar “AI Agents”

- Klik op Edit bij de juiste chatbot

2. Open het tabblad 'Knowledge Base'

- Kies in het zijmenu voor “Websites”

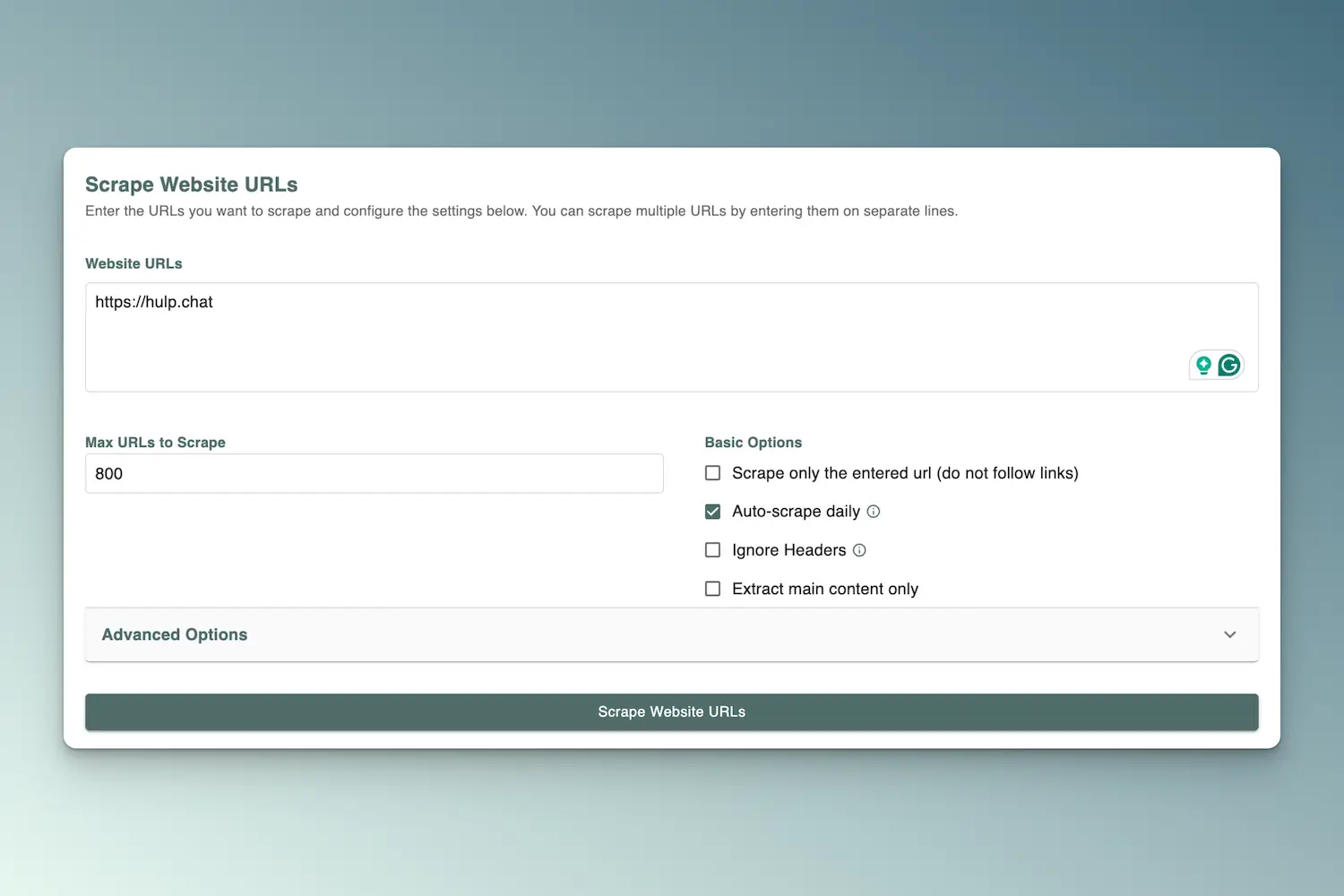

3. Voeg je website-URL(s) toe

- Vul één of meerdere URLs in (één per regel)

- Stel eventueel in:

- Maximaal aantal pagina’s (bijv. 500)

- Dagelijks automatisch scrapen

- De scraper draait precies 24 uur na de eerste scrape óf dagelijks om 02:00pm uur (UTC).

- Headers negeren

- Waarschuwing: Schakel deze optie alleen in als je URLs zonder kopteksten wilt scrapen.

- Alleen hoofdinhoud scrapen

Klik vervolgens op “Scrape Website URLs”

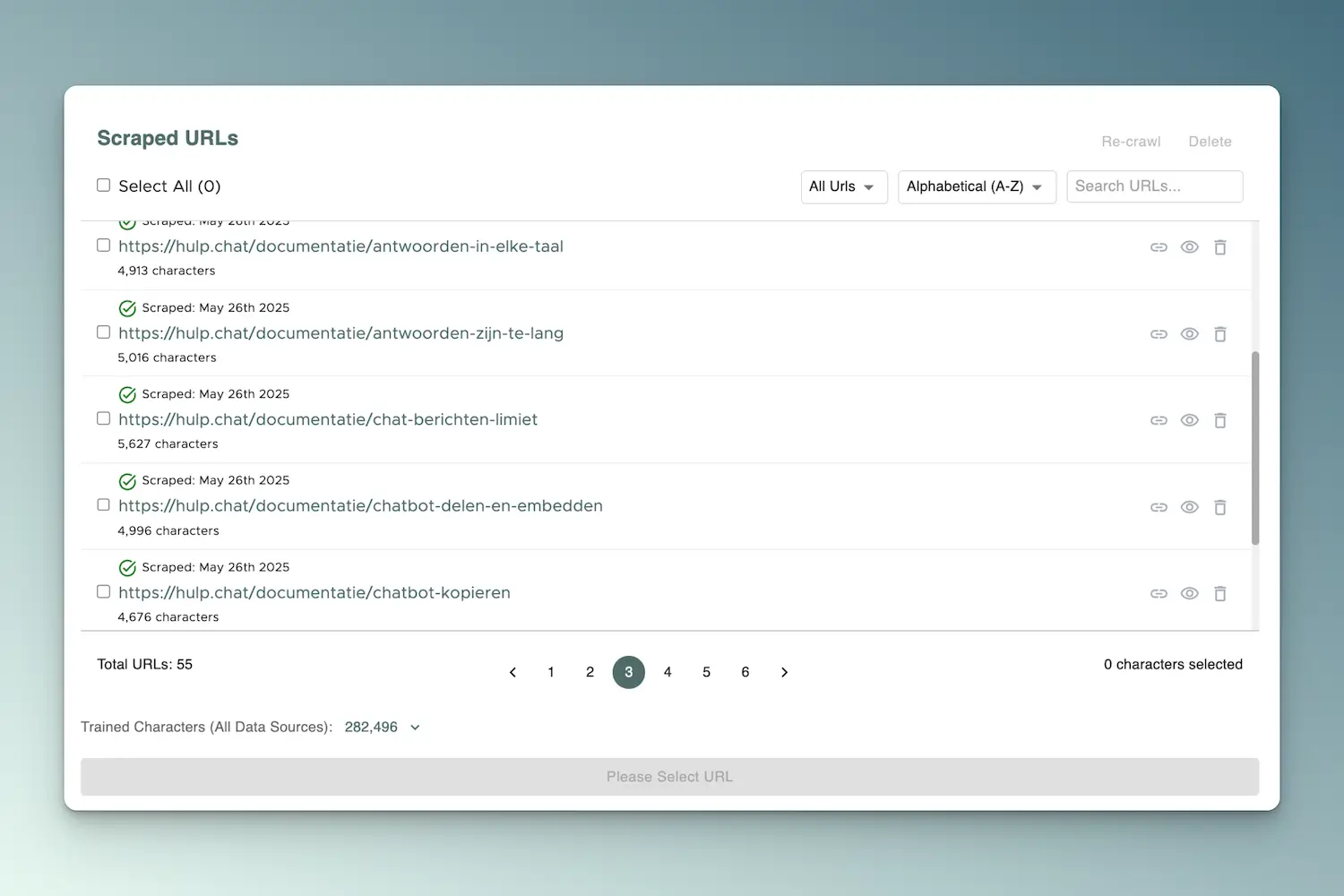

4. Bekijk gescrapete URLs

- Ga naar het subtapblad “Scraped URLs”

- Hier zie je alle gescande pagina’s, inclusief datum en tekengrootte

5. Verwijder onnodige content

- Controleer de lijst

- Verwijder irrelevante of automatisch gegenereerde pagina’s (zoals bijvoorbeeld: /privacy, /cookiebeleid)

6. Hertrain de AI-agent

- Klik onderaan op “Re-train AI Agent”

- De AI leert nu van de nieuwe, opgeschoonde data

Extra tips

- Gebruik de zoekfunctie om specifieke pagina’s terug te vinden

- Sorteer op naam of datum om snel recente aanpassingen te vinden

- Voeg ook een publieke Google Doc toe als kennisbron (mits openbaar)